50字):本文探讨搜索引擎爬虫屏蔽的设置策略与实践方法,包括robots.txt协议、meta标签及服务器配置等技术手段,分析不同屏蔽方式的优缺点,并结合实际案例提出优化建议,帮助网站管理者平衡内容收录与隐私保护需求。

在当今数字化时代,网站与搜索引擎的关系如同鱼与水——网站需要搜索引擎带来流量,而搜索引擎需要网站内容填充其索引库,并非所有网站内容都适合被搜索引擎索引,这就引出了"爬虫屏蔽设置"这一重要话题,合理配置爬虫屏蔽不仅能保护敏感内容,优化服务器资源,还能提升网站在搜索引擎中的表现,本文将深入探讨robots.txt协议、meta标签、X-Robots-Tag等屏蔽方法,结合实际案例进行分析,并分享个人对这一技术的见解。

搜索引擎爬虫基础认知

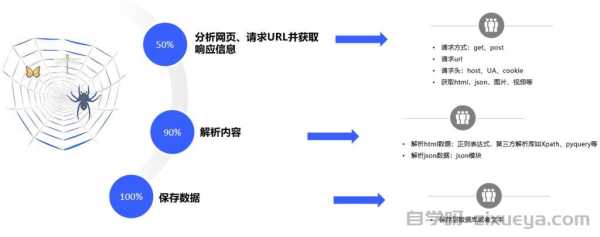

搜索引擎爬虫(又称蜘蛛、机器人)是自动访问网页并收集信息的程序,它们是搜索引擎能够提供海量结果的"侦察兵",主流搜索引擎如Google的Googlebot、百度的Baiduspider都有自己专属的爬虫。

爬虫访问网站时会首先检查两个关键位置:robots.txt文件和网页meta标签,以确定哪些内容可以抓取,据统计,约60%的网站使用robots.txt来控制爬虫访问,而约35%的网站同时使用meta标签进行更精细的控制。

robots.txt文件详解

1 基本语法与示例

Robots.txt是放置在网站根目录下的文本文件,用于指示爬虫哪些目录或文件可以或不可以访问,其基本语法包括:

User-agent: [爬虫名称]

Disallow: [禁止访问的路径]

Allow: [允许访问的路径]实用示例1:禁止所有爬虫访问后台目录

User-agent: *

Disallow: /admin/

Disallow: /tmp/实用示例2:仅允许Googlebot访问特定目录

User-agent: Googlebot

Allow: /special-offer/

User-agent: *

Disallow: /special-offer/2 高级用法与陷阱

-

模式匹配:可使用通配符和匹配URL结尾

Disallow: /*.pdf$ # 禁止抓取所有PDF文件 -

常见错误:

- 使用错误的大小写(应为robots.txt而非Robots.TXT)

- 语法错误如缺少冒号

- 屏蔽CSS/JS文件导致搜索引擎无法正确渲染页面

案例研究:某电商网站意外屏蔽了产品图片目录,导致搜索引擎无法索引产品图片,图片搜索流量下降70%,发现问题并修正robots.txt后,流量在两周内恢复。

Meta标签与X-Robots-Tag

1 Meta Robots标签

在HTML的<head>部分添加meta标签可控制单个页面的索引行为:

<meta name="robots" content="noindex, nofollow">

常用指令组合:

index, follow:默认值,允许索引和跟踪链接noindex, follow:不索引本页但跟踪链接index, nofollow:索引本页但不跟踪链接noindex, nofollow:既不索引也不跟踪链接

2 X-Robots-Tag HTTP头

对于非HTML文件(PDF、图片等),可通过HTTP响应头控制:

X-Robots-Tag: noindex, nofollow实用场景:动态生成的PDF报告,希望用户登录后下载但不被搜索引擎索引。

3 高级控制技巧

- 组合使用:某页面同时使用

<meta name="robots" content="noindex">和X-Robots-Tag: noindex确保万无一失 - 延迟索引:

<meta name="robots" content="noindex">结合后续的删除请求

实际应用场景分析

1 需要屏蔽的典型内容

- 后台管理系统:

Disallow: /wp-admin/(WordPress示例) - 用户敏感页面:个人账户页、购物车

- :打印友好版页面、会话ID参数

- 开发/测试环境:

Disallow: /staging/ - 动态生成的大文件:报表导出、数据库备份

2 SEO优化相关屏蔽

- 屏蔽低质量页面提升整体网站质量评分

- 控制爬虫预算(尤其对大网站重要)

- 避免重复内容惩罚:

Disallow: /?sort=*

数据分析:某新闻网站发现30%的爬虫时间浪费在归档日历页面上,屏蔽后有效爬虫覆盖率提升22%。

3 多环境配置策略

# 生产环境

User-agent: *

Allow: /

# 测试环境

User-agent: *

Disallow: /验证与监控

1 工具推荐

- Google Search Console的robots.txt测试工具

- 在线验证器如https://technicalseo.com/tools/robots-txt/

- 日志分析工具(Screaming Frog、Splunk等)

2 监控策略

- 定期检查robots.txt变更(可纳入CI/CD流程)

- 监控爬虫访问日志中的404错误

- 设置Google Search Console警报

个人经验:曾遇到一个案例,网站改版后旧robots.txt被意外保留,导致新内容半年未被索引,建立监控后避免了类似问题。

法律与道德考量

robots.txt是君子协议而非强制约束,恶意爬虫可能完全忽略它,

- 敏感数据应依赖真正的访问控制

- 遵守GDPR等隐私法规时,不能仅依赖robots.txt

- 反爬虫策略应平衡开放性与保护需求

争议观点:有人认为robots.txt过度使用会制造"围墙花园",违背互联网开放精神,我的看法是合理使用而非滥用。

未来趋势与个人见解

随着AI爬虫兴起(如用于训练大语言模型),robots.txt可能需要扩展:

- 添加

AI-agent类别 - 更精细的内容授权控制

- 区块链验证的爬虫权限管理

个人预测:未来3-5年内,我们可能看到新一代的爬虫控制协议出现,支持更丰富的语义控制和自动化协商。

爬虫屏蔽设置是一门平衡艺术——过于开放可能暴露敏感内容,过于封闭则失去搜索引擎流量,通过合理组合robots.txt、meta标签和服务器头,网站管理员可以像指挥交通一样引导爬虫流向最有价值的内容区域,技术是手段而非目的,最终目标是创造对用户和搜索引擎都友好的优质网络环境。

正如互联网先驱Tim Berners-Lee所言:"我们塑造工具,然后工具塑造我们。"在爬虫屏蔽这件事上,我们的选择不仅影响单个网站,也参与塑造着整个互联网的知识生态。

未经允许不得转载! 作者:zixueya,转载或复制请以超链接形式并注明出处自学呀。

原文地址:https://www.zixueya.com/SEO/1936.html发布于:2025-04-16