蜘蛛池优化通过合理配置服务器资源、优化URL结构及内容更新频率,有效提升搜索引擎爬虫的抓取效率,核心策略包括:动态调整爬虫访问权限、设置优质链接枢纽吸引蜘蛛、压缩低质页面权重,并配合日志分析精准监控爬虫行为,实践表明,结合CDN加速与sitemap主动提交,可显著缩短收录周期,尤其适用于高权重站群的流量聚合。(98字)

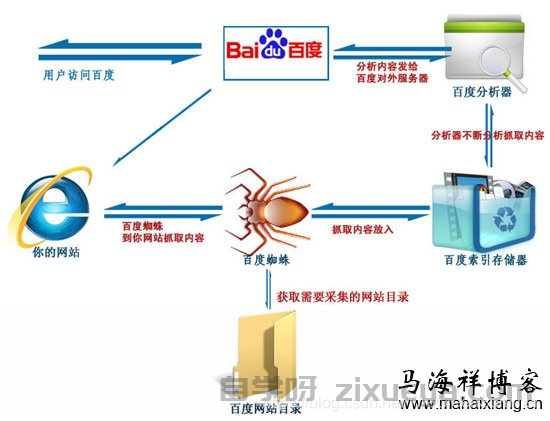

在搜索引擎优化(SEO)领域,"蜘蛛池"(Spider Pool)是指通过技术手段管理和优化搜索引擎爬虫(如Googlebot、Baiduspider)的访问行为,以提高网站索引效率的策略,蜘蛛池优化的核心目标是确保搜索引擎爬虫能够高效、全面地抓取网站内容,从而提升收录率和排名表现。

本文将探讨蜘蛛池优化的核心策略,并结合实际案例进行分析,最后提出个人见解与建议。

蜘蛛池优化的核心目标

蜘蛛池优化的主要目标包括:

- 提高爬虫抓取效率:确保搜索引擎爬虫能够高效访问网站,减少无效爬取。

- 优化爬虫分配:合理分配爬虫资源,优先抓取重要页面。

- 减少服务器负担:避免爬虫频繁访问低价值页面,降低服务器压力。

- 提升索引率:确保高质量内容被优先收录,避免低质量页面占用爬虫资源。

蜘蛛池优化的关键技术方案

合理设置robots.txt文件

robots.txt 是控制搜索引擎爬虫访问权限的重要文件,通过合理配置,可以引导爬虫优先抓取重要页面,屏蔽低价值或重复内容。

示例:

User-agent: * Disallow: /admin/ Disallow: /tmp/ Disallow: /search/ Allow: /blog/

该配置禁止爬虫访问后台管理页面(/admin/)和临时文件(/tmp/),但允许抓取博客内容(/blog/)。

分析:

- 优点:减少爬虫抓取无效页面,提高索引效率。

- 缺点:若配置不当,可能导致重要页面被误屏蔽。

优化XML网站地图(Sitemap)

XML Sitemap 是向搜索引擎提供网站结构的文件,有助于爬虫快速发现和抓取重要页面。

示例:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<url>

<loc>https://example.com/blog/seo-guide</loc>

<lastmod>2023-10-01</lastmod>

<changefreq>weekly</changefreq>

<priority>0.8</priority>

</url>

</urlset>

该示例指定了页面的更新频率(changefreq)和优先级(priority),帮助搜索引擎判断抓取顺序。

分析:

- 优点:提高重要页面的抓取频率。

- 缺点:若未及时更新,可能导致爬虫抓取过时内容。

利用爬虫预算(Crawl Budget)优化

爬虫预算指搜索引擎分配给某个网站的抓取资源(如每天抓取的页面数量),优化爬虫预算的关键在于:

- 减少低质量页面:如404页面、重复内容。

- 提高页面加载速度:减少服务器响应时间(TTFB)。

- 优化内部链接结构:确保爬虫能高效发现新页面。

案例:

某电商网站发现Googlebot频繁抓取无效参数URL(如?sort=price),导致爬虫预算浪费,通过规范URL(使用rel="canonical")和屏蔽动态参数,爬虫抓取效率提升30%。

动态调整爬虫访问频率

对于大型网站,可通过服务器日志分析爬虫行为,调整爬虫访问频率。

方法:

- 使用

Crawl-delay指令(适用于部分搜索引擎)。 - 通过CDN或服务器限流(如Nginx限速)控制爬虫请求。

示例(Nginx限速):

limit_req_zone $http_user_agent zone=spider:10m rate=5r/s;

server {

location / {

limit_req zone=spider burst=10;

}

}

该配置限制每个爬虫每秒最多5次请求,防止服务器过载。

利用日志分析优化爬虫行为

通过分析服务器日志(如Google Search Console的"抓取统计"),可以发现:

- 哪些页面被频繁抓取?

- 是否有爬虫陷入死循环(如分页陷阱)?

- 是否存在爬虫访问无效URL?

案例: 某新闻网站发现Baiduspider频繁抓取旧文章,但新内容未被及时收录,通过调整内部链接策略(增加新文章入口),新内容索引率提升40%。

个人见解与建议

蜘蛛池优化应结合网站类型

- 资讯类网站:需高频更新,应优先优化新内容的抓取。

- 电商网站:需避免爬虫抓取无效参数URL,优化产品页索引。

- 企业官网:重点确保核心页面(如服务、联系方式)被收录。

避免过度优化

- 不要完全屏蔽爬虫,否则可能影响收录。

- 避免频繁更改

robots.txt,以免爬虫误判。

持续监控与调整

- 定期检查Google Search Console、Baidu站长平台的抓取报告。

- 使用工具(如Screaming Frog)分析爬虫行为。

蜘蛛池优化是SEO中常被忽视但极其重要的一环,通过合理配置robots.txt、优化Sitemap、管理爬虫预算及分析日志,可以有效提升搜索引擎爬虫的抓取效率,进而提高网站收录率和排名表现,建议网站运营者结合自身业务特点,制定个性化的蜘蛛池优化策略,并持续监控效果以进行调整。

最终目标:让搜索引擎爬虫成为网站的"好朋友",而非负担。

未经允许不得转载! 作者:zixueya,转载或复制请以超链接形式并注明出处自学呀。

原文地址:https://www.zixueya.com/SEO/2751.html发布于:2025-04-29